微软将数万颗芯片串联成一台价格不菲的超级计算机用于OpenAI

OpenAI试图训练一套越来越大的被称为模型的人工智能程序,这些程序正在吸收更多的数据,并学习越来越多的参数,即人工智能系统通过训练和再训练而发现的变量。这意味着OpenAI需要长期使用强大的云计算服务。

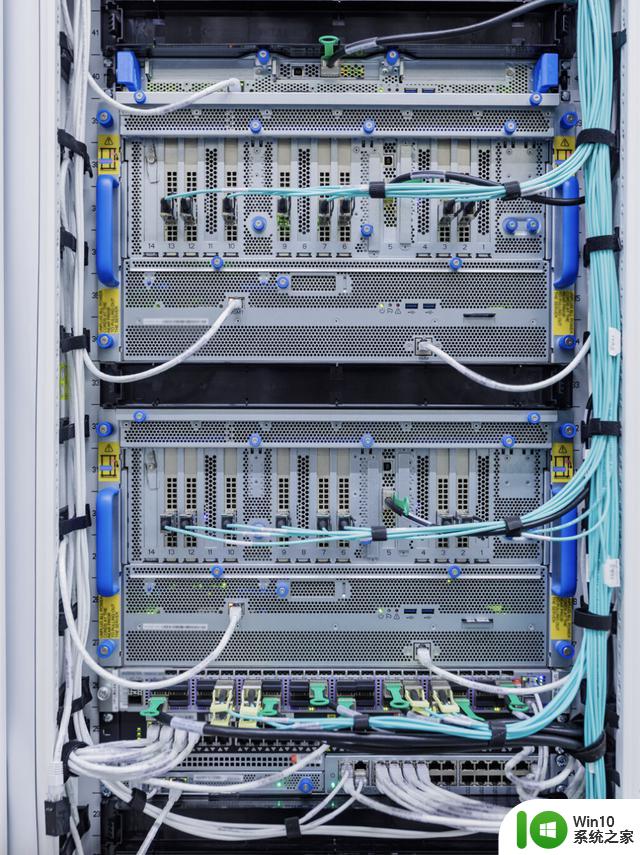

为了应对这一挑战,微软不得不想方设法将数以万计的英伟达的A100图形芯片--训练人工智能模型的主力--串联起来,并改变其在机架上放置服务器的方式以防止断电。负责云计算和人工智能的微软执行副总裁Scott Guthrie不愿透露该项目的具体成本,但他说"可能会大于"几亿美元。

这项技术让OpenAI发布了ChatGPT,这一具有强大语言天赋的聊天机器人在11月上市后几天内就吸引了100多万用户。现在正被拉入其他公司的商业模式,从亿万富翁对冲基金创始人Ken Griffin经营的公司到食品配送服务Instacart Inc. 随着ChatGPT等生成型人工智能工具获得企业和消费者的兴趣,微软、亚马逊公司和Alphabet公司旗下的Google等云服务提供商将面临更多压力。以确保其数据中心能够提供所需的巨大计算能力。

现在,微软使用它为OpenAI建立的同一套资源来训练和运行自己的大型人工智能模型,包括上个月推出的新的Bing搜索机器人。它还将该系统出售给其他客户。这家软件巨头已经开始着手开发下一代人工智能超级计算机,这是微软与OpenAI扩大交易的一部分,微软在其中增加了100亿美元的投资。

训练一个大规模的人工智能模型需要像微软组装的人工智能超级计算机那样,在一个地方有一个大型的连接图形处理单元池。一旦一个模型投入使用,回答用户提出的所有查询--称为推理--需要一个稍微不同的设置。微软也部署了用于推理的图形芯片,但这些处理器--数十万个--在地理上分散在该公司60多个地区的数据中心中。 现在,该公司正在为人工智能工作负载添加最新的NVIDIA图形芯片--H100--和NVIDIA最新版本的Infiniband网络技术。以更快地分享数据,微软周一在一篇博文中说。

新的必应仍处于预览阶段,微软正在逐步从等待名单中增加更多的用户。微软的AI团队每天与大约二十几名员工举行会议,他们被称为"维修人员",因为他们是在比赛中调整赛车的机械师。该小组的工作是弄清楚如何快速上线更多的计算能力,以及解决出现的问题。

云服务依赖于数以千计的不同部件和物品--服务器、管道、建筑物的混凝土、不同的金属和矿物等各个部分--任何一个部件的延迟或短缺,无论多么微小,都会使一切都中断。最近,维修人员不得不处理电缆托架的短缺问题--这种篮子一样的装置用来放置机器上的电缆。所以他们设计了一种新的电缆盘,微软可以自己生产或找地方购买。他们还在研究如何在世界各地现有的数据中心中尽可能多地压缩服务器,这样他们就不必等待新的建筑完工。

当OpenAI或微软正在训练一个大型的人工智能模型时,工作在一个时间段内发生,它被分到所有的GPU上,在某些时候,这些单元之间需要相互交谈,以分享它们所做的工作。对于人工智能超级计算机,微软必须确保处理所有芯片之间通信的网络设备能够处理这种负载,而且它必须开发软件,使GPU和网络设备得到最佳利用。该公司现在已经提出了一个软件,可以让它训练具有几十万亿个参数的模型。

因为所有的机器都是一次性启动的,所以微软必须考虑到它们的放置位置和电源的位置,否则你就会出现像在厨房里同时打开微波炉、烤面包机和吸尘器一样的过载问题。

Azure全球基础设施总监Alistair Speirs说,该公司还必须确保它能够冷却所有这些机器和芯片,在较凉爽的气候下使用外部空气,在炎热的气候下使用更高技术的冷却装置。

微软将继续研究定制的服务器和芯片设计以及优化其供应链的方法,以获得任何速度上的提高、效率和成本上的节省。