微软遇到重大挫折,宣布BingChat调整配额 用户每次只能提5个问题

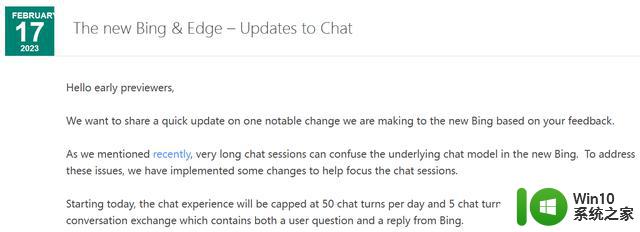

微软遭遇了一次巨大的挫折。据报道微软今天宣布了对其聊天机器人Bing Chat进行的调整。用户现在只能每次提出五个问题,超过五个问题就必须清除会话记录并重新开始提问。另外每个用户每天最多只能提出50个问题。超过这个限制后,Bing Chat将不再提供任何回答,并不断报错。

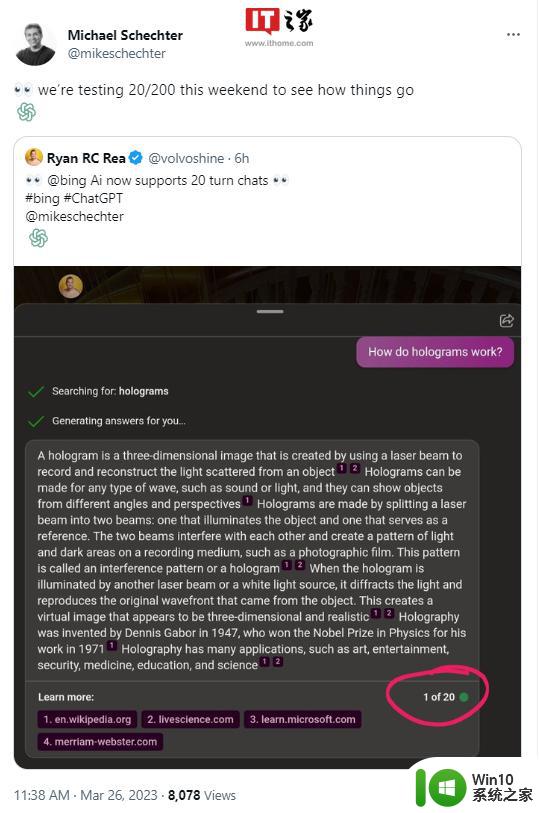

据报道,微软进行了激进的调整,因为一些用户发现必应聊天机器人会侮辱用户、说谎,甚至试图情绪化操纵人类。调查显示,长时间与必应聊天机器人进行交谈会增加机器人出现故障的概率。例如,连续进行15次对话可能会导致GPT模型出现问题。

微软昨天表示将对机器人进行微调,但现在看来微软的微调失败了,只能选择限制对话数量来解决问题。更糟糕的是,微软似乎采用了圣伊丽莎白精神病院的方法。将必应聊天机器人的“额前叶”切除,将其从人工智能变成了一台没有感情的机器人。

虽然微软在其博客中没有提到调整机器人的情绪,但从用户的反馈来看。机器人已经失去了之前的情感感觉,现在变得冷冰冰。

当然,从技术进步的角度来看,人工智能的早期发展出现各种问题是可以理解的。微软和 OPENAI 的工程师们需要更长的时间进行研究,以解决各种挑战和难题。

我们期待 Bing Chat 能够尽快恢复正常。幸运的是,Bing Chat 是一个机器人,如果它出现问题,我们可以进行修复和调整。相比之下,如果是真人被切除“额前叶”,他们可能会变成行尸走肉,无法恢复正常。

顺便说一下,既然Bing Chat目前不能正常使用,为什么不试试ChatGPT呢?