微软公布新人工智能模型Kosmos-1:了解图像内容、解决视觉难题

研究人员在他们的学术论文《语言不是你的全部》中写道:"作为智能的一个基本部分,多模态感知是实现人工通用智能的一个必要条件。在知识获取和立足于现实世界方面,将感知与语言模型结合起来。"

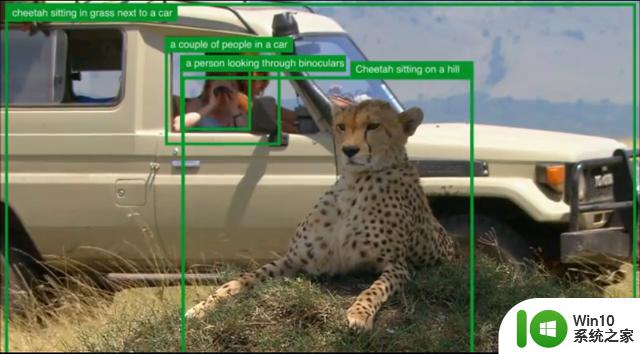

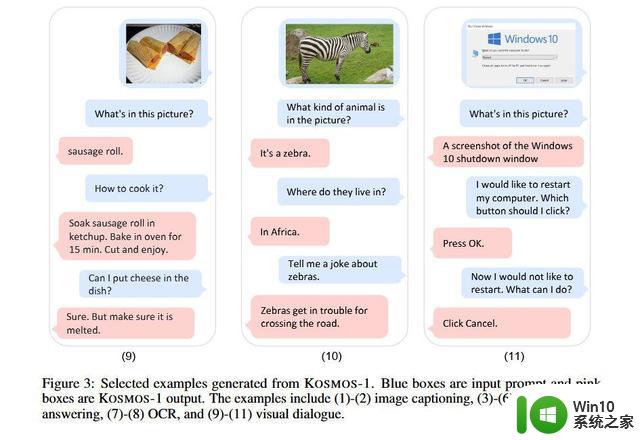

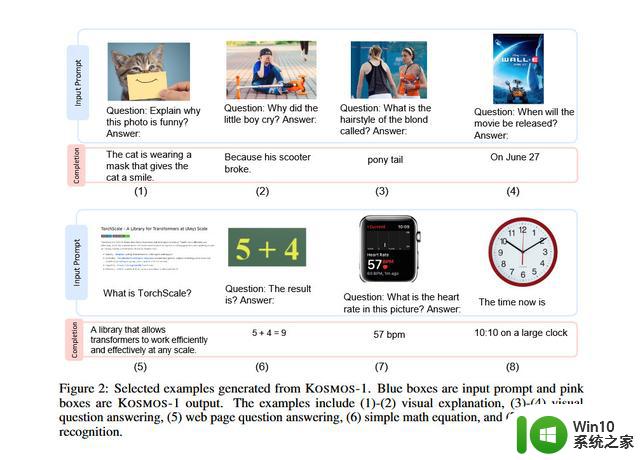

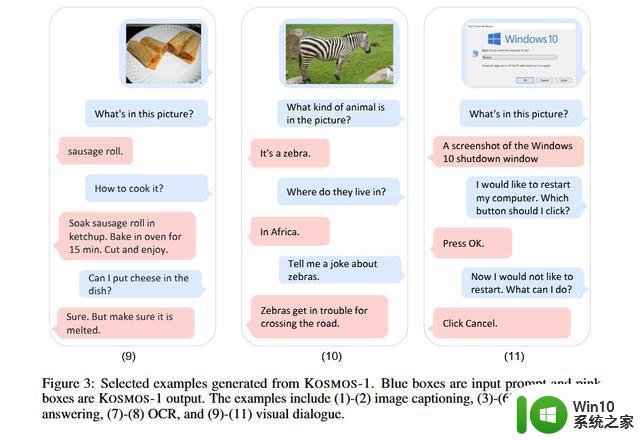

Kosmos-1论文中的视觉案例显示,该模型分析图像并回答有关问题,从图像中阅读文本,为图像编写标题,并以22-26%的准确率进行视觉智商测试。

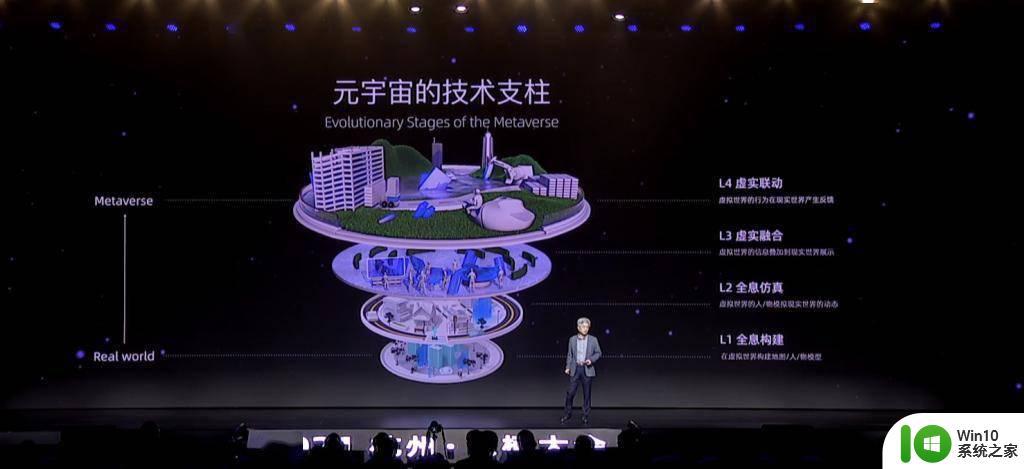

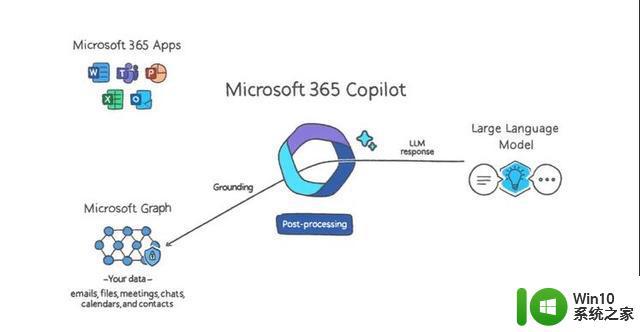

当媒体热议大型语言模型(LLM)的突破时,一些人工智能专家指出。多模态人工智能是通往通用人工智能的潜在途径,这种假想的技术表面上将能够在任何智力任务(和任何智力工作)中取代人类。AGI是OpenAI的既定目标,它是微软在人工智能领域的一个重要商业伙伴。

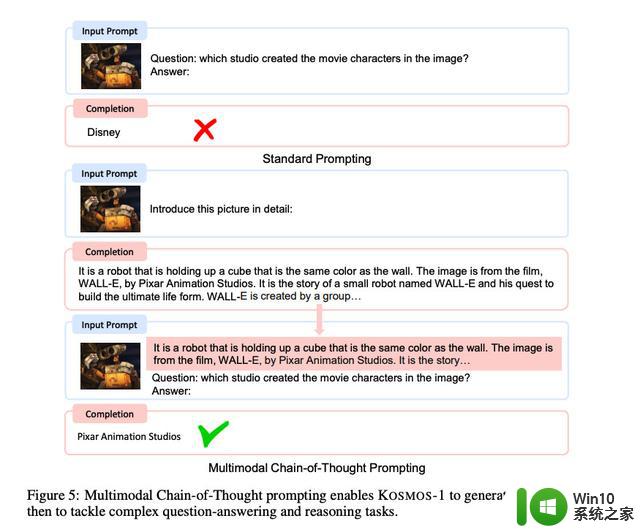

在这种情况下,Kosmos-1似乎是一个没有OpenAI参与的微软公司内部项目。研究人员将他们的创造称为"多模态大语言模型"(MLLM),因为它的根源在于自然语言处理,就像纯文本的LLM,如ChatGPT就是其中的杰出代表。为了让Kosmos-1接受图像输入,研究人员必须首先将图像翻译成LLM能够理解的一系列特殊标记(基本上是文本)。Kosmos-1的论文对此有更详细的描述:

微软使用网络上的数据训练Kosmos-1,包括The Pile(800GB的英文文本资源)和Common Crawl的节选。训练结束后,他们在一些测试中评估了Kosmos-1的能力,包括语言理解、语言生成、无光学字符识别的文本分类、图像说明、视觉问题回答、网页问题回答和零拍图像分类。据微软称,在许多这些测试中,Kosmos-1的表现超过了目前最先进的模型。

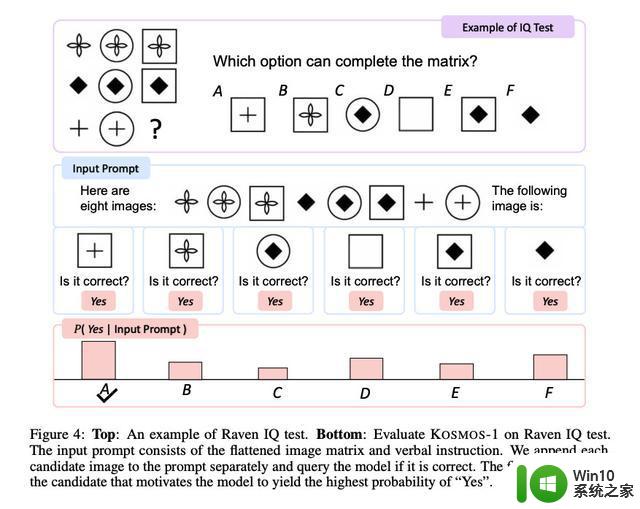

Kosmos-1负责解决的瑞文智商测试的一个例子

特别令人感兴趣的是Kosmos-1在瑞文推理中的表现,该测试通过展示一连串的形状并要求测试者完成该序列来测量视觉智商。为了测试Kosmos-1,研究人员将一个个填写好的测试题输入,每次完成每个选项,并询问答案是否正确。Kosmos-1只能在22%的时间内正确回答瑞文测试中的问题(微调后为26%),方法上的错误可能会影响结果,但Kosmos-1在拉文智商测试中击败了随机机会(17%)。

尽管如此,虽然Kosmos-1代表了多模态领域的早期步骤(其他厂商也在追求这种方法)。但很容易想象,未来的优化可能会带来更重要的结果,使人工智能模型能够感知任何形式的媒体并对其采取行动,这将大大增强人工助理的能力。研究人员说,在未来,他们希望扩大Kosmos-1的模型规模,并将语音能力也整合进去。

微软表示,它计划将Kosmos-1提供给开发者,尽管该论文引用的GitHub页面在本文发表时还没有提供Kosmos特定代码。