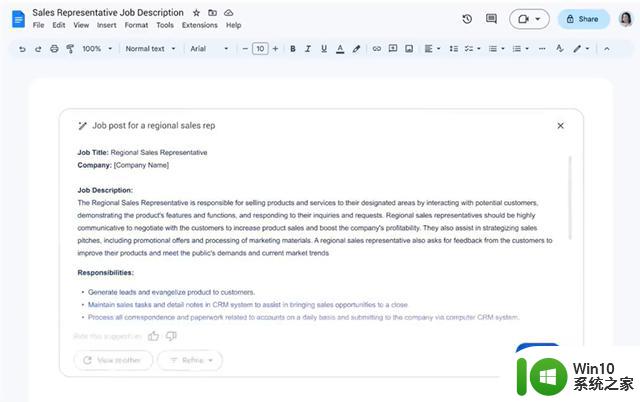

AI大赛中谷歌追赶微软背后:内部员工因伦理担忧曾试图阻止

据媒体的最新曝光,两名前谷歌员工表达了他们对公司发布新的AI聊天机器人的担忧。

今年3月,两名负责审查AI产品的谷歌员工试图阻止该公司推出自己的AI聊天机器人,他们认为该技术会产生“不准确和危险的陈述”。

几个月前,微软的伦理学家也提出了类似的担忧。他们认为,这种AI聊天机器人将令用户批判性思维的退化,同时可能会充斥虚假信息和侵蚀“现代社会的事实基础”。

尽管如此,微软依然在2月发布了其集成在Bing搜索引擎的聊天机器人;一个月后,谷歌在3月底发布了其Bard聊天机器人。

有媒体分析称,这些通常在规避风险方面十分谨慎的大公司之所以在AI领域不管不顾地采取激进的举措,是为了在下一场可能的科技竞赛中占得先机。

根据多名员工及内部文件的阐述,ChatGPT的惊人成功导致微软和谷歌愿意承担更大的风险。微软技术主管Sam Schillace上个月发送的一封内部电子邮件称,第一个推出相关产品的公司将是长期赢家。有时候两家公司的差距仅仅以周为单位。

自发布以来,围绕这些AI机器人的伦理争议就持续不断。包括马斯克在内的1000多名技术领域的研究人员和意见领袖不久前发布一封公开信表达了对AI带给社会影响的担忧,他们呼吁放慢相关技术的发展步伐。

监管机构已经准备对AI技术进行干预。欧盟提议立法监管人工智能,意大利上周暂时禁止ChatGPT。在美国,白宫和国会也在寻求对AI更强有力的监管。

更令外界担忧的是,上个月底。微软、Meta、谷歌、亚马逊和推特等公司都裁减了“负责任的人工智能团队”成员,这些团队主要为使用人工智能的消费产品的安全性提供建议。

业内专家对此表示,各大科技公司裁减相关人员的决定令人担忧,因为随着越来越多的人开始试用新的人工智能工具,人们发现了这项技术可能被滥用。在OpenAI推出ChatGPT并取得成功后,人们的这种担忧进一步加剧。

谷歌旗下人工智能研究公司DeepMind的前伦理和政策研究员、研究机构Ada Lovelace Institute副主任Andrew Strait称:

今年1月,微软解散了其“道德和社会”团队。该团队领导了微软在相关领域的早期工作。微软表示,裁员人数不到10人,公司负责人工智能的办公室仍有数百人在工作。

微软人工智能业务主管Natasha Crampton称:

本文来自华尔街见闻,欢迎下载APP查看更多